Nvidia revela a nova placa HGX H200 para servidores focados em IA

A NVIDIA tem investido consideravelmente no desenvolvimento de tecnologias focadas para a Inteligência Artificial, e tem sido também uma das principais fontes de receitas da empresa nos últimos meses. Portanto, não será de admirar que a entidade tenha agora revelado a sua próxima geração de placas gráficas, focado para uso neste mercado.

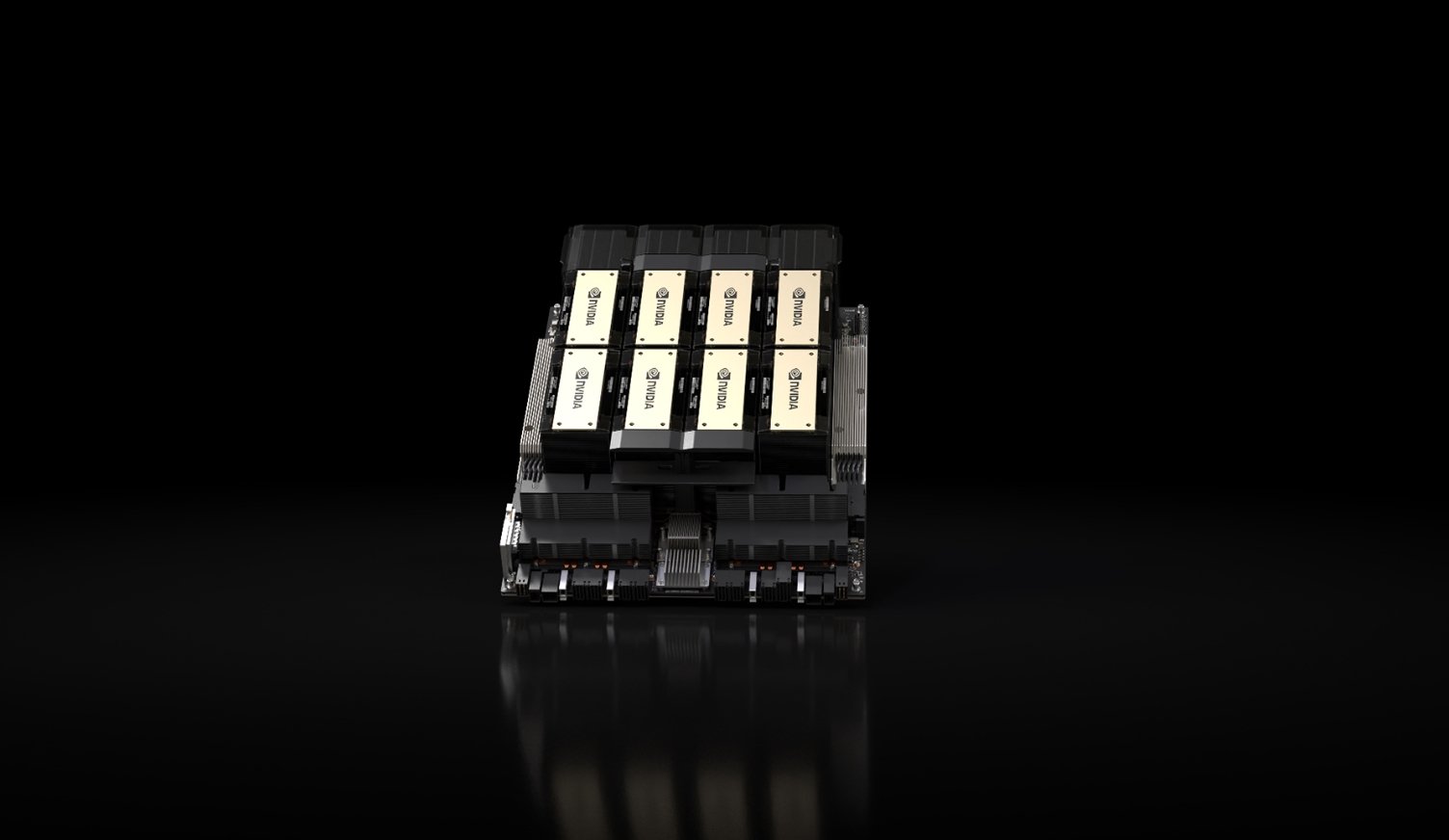

A NVIDIA confirmou hoje as suas novas placas HGX H200, baseadas na arquitetura do chip Hopper e nos Tensor Core H200. Esta nova placa será a primeira a oferecer suporte para HBM3e, um novo formato de memória que permite velocidades de transmissão de dados ainda mais rápidas, e de maior volume, focando-se exatamente no processamento de dados para uso de modelos LLM. Com o uso da tecnologia HBM3e, as placas podem permitir até 141 GB de memória a 4.8 Tbps de transmissão de dados, o que corresponde a mais do dobro da velocidade obtida com a geração anterior da NVIDIA A100.

Ao mesmo tempo, a empresa garante ainda que o novo chip será capaz de fornecer um desempenho consideravelmente superior para tarefas de processamento associadas com IA generativa. A empresa compara o uso do modelo Llama 2, que fornece o dobro da velocidade neste chip em comparação com o H100. A NVIDIA afirma ainda que entidades como a Microsoft Azure, AWS, Google Cloud e Oracle Cloud já terão assinado contratos para adquirirem as primeiras unidades da HGX H200.

Além disso, a empresa afirma ainda que se encontra a trabalhar com os parceiros na criação de hardware de servidores, como a ASRock Rack, ASUS, Dell Technologies, GIGABYTE, Hewlett Packard Enterprise, Lenovo, entre outras, para adaptarem as suas configurações anteriores baseadas para sistemas H100 de forma a suportarem os novos H200.

Obviamente, estas placas encontram-se longe de chegar aos consumidores em geral, sendo focadas para empresas e centros de dados que pretendam melhorar as suas capacidades de IA generativa.