Project Astra da Google usa IA para “ver” o mundo em redor

Depois da OpenAI ter revelado o GPT-4o, capaz de “ver” e “ouvir” o meio onde se encontra, agora a Google revela a sua própria tecnologia similar.

Durante o evento I/O, a Google revelou o novo Project Astra, que se foca em desenvolver um novo modelo de IA, capaz de analisar o mundo em redor dos utilizadores, e fornecer informações com base no que “vê”.

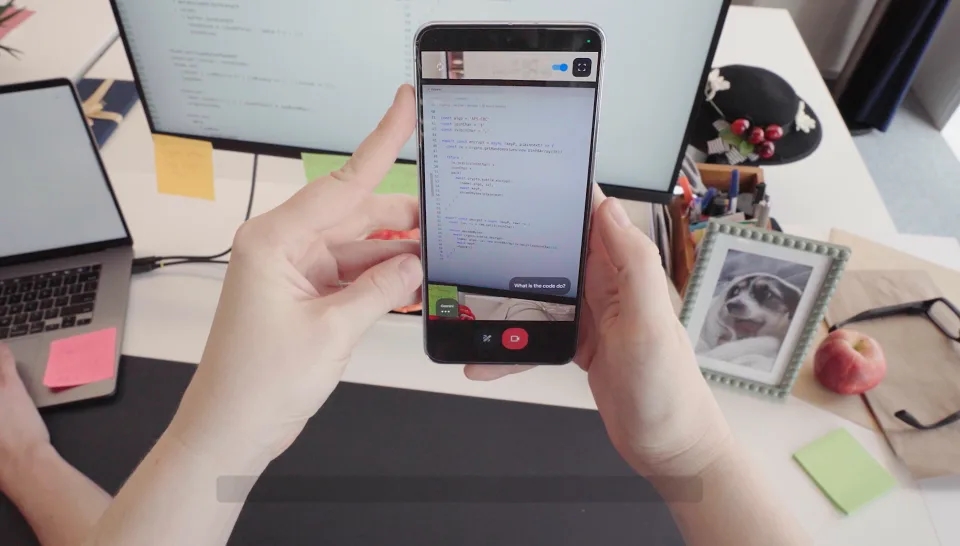

A Google revelou alguns detalhes sobre este projeto durante a sua apresentação. No vídeo da empresa, a demonstração apresenta um smartphone, que aparenta ter uma app dedicada do Gemini aberta, e que está ativamente a analisar o que é apontado.

A pessoa a segurar no dispositivo vai colocando várias questões sobre o que está a ser apresentado no momento, ao que o Gemini responde de forma natural e realista.

Por exemplo, a pessoa pergunta ao Gemini para indicar um objeto na sua frente que produza sons, ao que o Gemini aponta uma coluna de computador presente na cena.

A aplicação parece ainda ter a capacidade de analisar alguns objetos interativos. Na demonstração, a pessoa marca uma parte da coluna, e pede ao Gemini para lhe indicar qual o nome da mesma – ao que o modelo de IA responde corretamente.

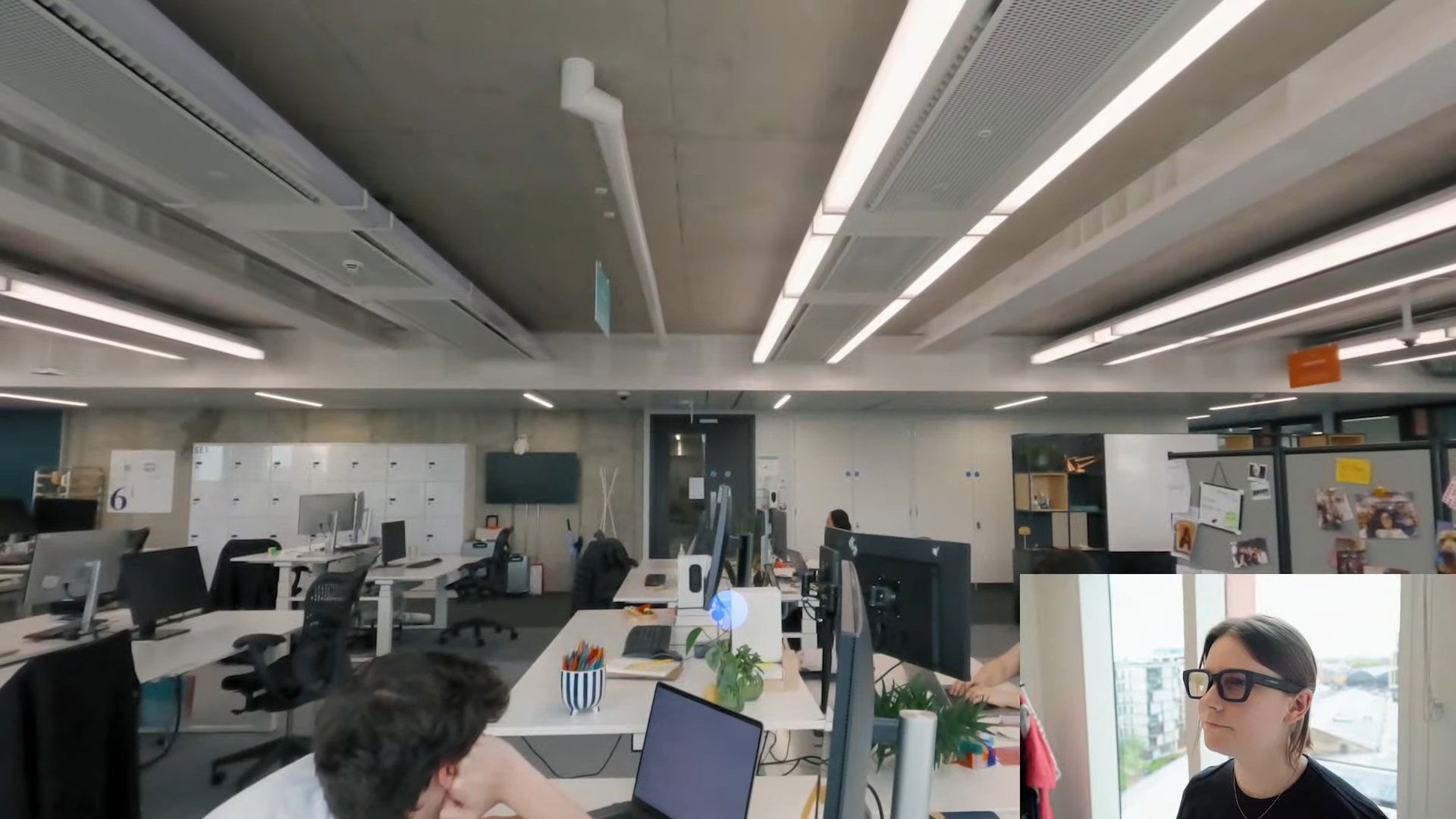

No entanto, o mais interessante deste vídeo surge na parte final, onde o mesmo apresenta o que parece ser os novos “Google Glass”, onde o Gemini se encontra integrado.

Na demonstração, a utilizador passa de usar o smartphone para usar o dispositivo de óculos, que regista o ambiente em seu redor em tempo real. Tal como acontecia no smartphone, é possível colocar questões ao Gemini sobre o que se encontra a ser apresentado.

Embora o Project Astra tenha certamente captado o interesse dos presentes no evento, a Google ainda não deixou detalhes de quando a tecnologia vai ficar disponível para os utilizadores em geral. Além disso, também não foram revelados detalhes sobre o que parece ser uma nova geração dos Google Glass.